Déjà, on demande a l’IA de générer 2 choses distincte, c’est compliqué pour lui, en utilisant StableDiffusion (ce qu’utilise mid journey), il a beaucoup de mal de générer des “concepts” avec des attributs indépendants:

“A red circle”

“A green square”

Demandez les 2 en meme temps, et l’IA est perdu:

“A green square and a red circle”

Notez la disparition total du cercle.

Notez la disparition total du cercle.

Et voici pour: “A girl with a blue shirt and a green jean.”

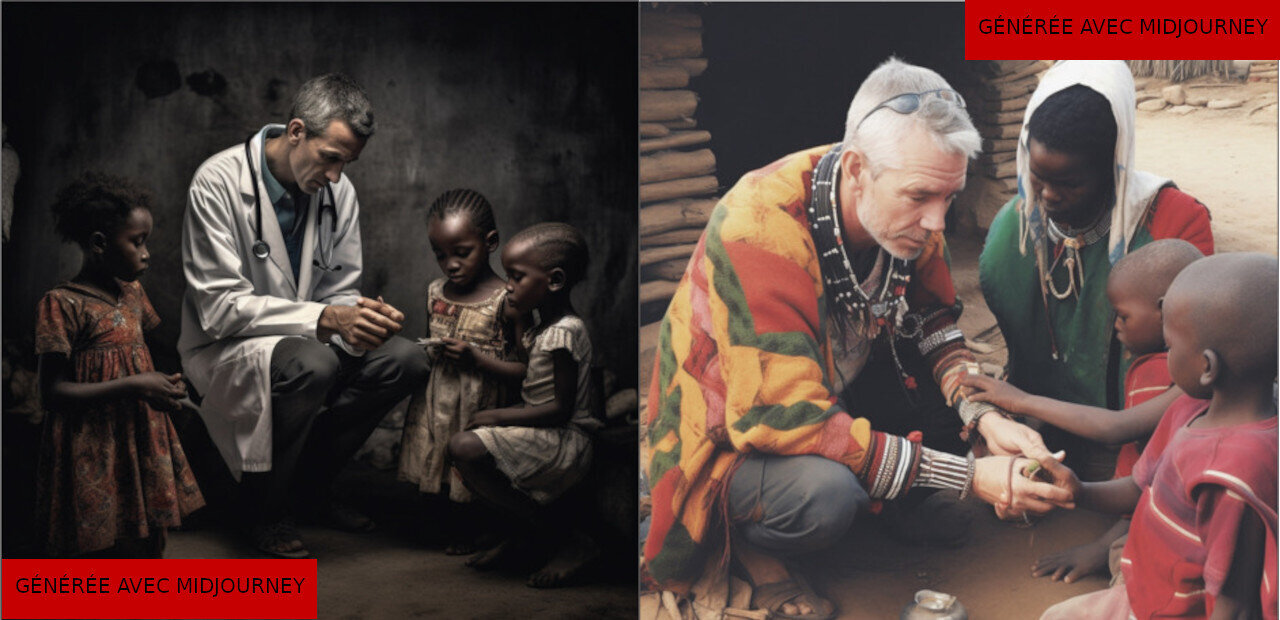

Du coup, oui l’IA va tomber rapidement dans les biais de ses données d’apprentissage si elle est pas assez intelligente pour comprendre ce qu’on lui demande.

Sauf que Dall-E 3 réussit les prompts que je viens de donner sans soucis.

Et si on lui demande ? Bein y’a pas de problème:

Edit:

Stable Diffusion a tellement du mal que le médecin va être un enfant assez fréquement (le mot “children” leak sur “doctor”)

On peut faire en sorte que Stable Diffusion comprenne mieux en donnant un coup de main en séparant les concepts.

Il existe un outil appellé “Cutoff” qui permet d’aider SD en limitant la portée des mots.

Avec la prompt “A (black doctor) attending (white childrens)”

Et en mettant le “cutoff” sur “black, white”, SD respecte (plus souvent) la demande (mais y’a plus d’occurence de médecins sans enfants):

Edit edit: Notez que, pour faire en sorte que l’IA fasse ce qu’on veut, c’est compliqué, j’ai mis des images pour illustrer, c’est partiellement un mensonge: l’image illustre ce que m’a sortit le plus fréquemment l’IA avec mes paramètres, il peut lui arriver de réussir infréquemment l’inverse de ce que j’illustre, ou ne respecte pas du tout ce que j’ai demandé.

Personellement, je pense que si l’étude de base voulait être sérieuse, il aurait fallus qu’il mesure déjà la confusion de base de l’IA, sur des sujets avec peu de biais, puis comparer avec un sujet biaisé.

Très intéressant, merci!

Et il faut aussi ajouter que ce genre d’article est extrêmement facile à faire: les chercheurs et ingés discutent de ces problèmes de composition et de biais en sont très conscient et ont des moyens d’y remédier. On procède par étapes, et le paradoxe c’est que chaque étape est une putain de révolution mais que du coup on est déçu quand on en trouve des limites.

Dalle e 3 est hyper impressionnant sur ce problème. Il interprète vraiment très bien les différents concepts et leurs relations.

L’article lié est payant et déforme l’article original.

L’article original (anglais) :

https://www.thelancet.com/journals/langlo/article/PIIS2214-109X(23)00329-7/fulltextMerci !

Article en anglais qui en parle : https://garymarcus.substack.com/p/race-statistics-and-the-persistent

Si j’ai bien compris,Le modèle de l’IA ne fait que répéter les caractéristiques qu’il voit beaucoup trop souvent . Dans l’article que j’ai partagé si dessus, l’auteur donne l’exemple des montres . Si vous demandez à L’IA l’image d’une montre a tel ou tel heure, elle ne donnera que des images avec des aiguilles pointées vers 10:10 car la majorité de sont entraînements s’est fait avec des images issues de magasin en ligne qui ont tous des miniatures d’image avec les montres qui pointent sur 10:10. La raison? Les vendeurs de montre considèrent que cella rend les montres plus attractives visuellement.

Faut voir ça comme si on donnait un exercice compliqué du genre à un gamin de 3 ans

Forcément si on lui a appris que (ou quasiment que) de faire des medecins blancs, le gamin va généraliser; et en général, il a appris que les médecins étaient blancs.

Les fois où on lui demandera un medecin noir, il nous dessinera un blanc et on lui donnera pas le bonbon.

N’empêche que dans 9 cas sur 10, il aura eu son bonbon sans avoir à regarder la suite de la phrase où on précise la couleur du medecinOn est tous comme ça sur pleins de sujets; si on apprenais tout par coeur on arriverait pas aussi bien à généraliser et à s’en sortir sur une tâche surprenante (c.f. l’histoire sur les Docteurs qui sont toujours imaginés comme étant des hommes et les infirmières comme des femmes)

Bon maintenant faut lui apprendre que ça nous fait quand même un peu chier qu’il lise pas la suite…